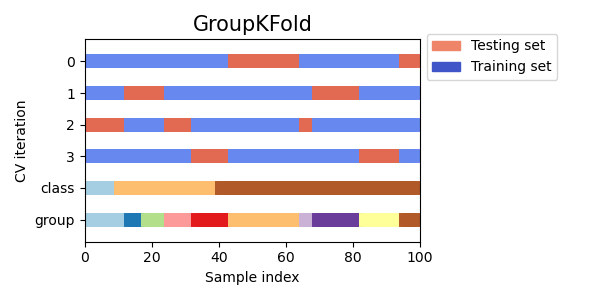

K折交叉验证

-

如何利用交互验证来提升模型评估的可靠性?

如何利用交互验证来提升模型评估的可靠性? 在机器学习中,模型评估是至关重要的一个环节。它帮助我们了解模型在未知数据上的表现,从而判断模型是否能够满足我们的需求。常用的评估方法包括训练集误差、测试集误差以及交叉验证。其中,交叉验证是一种...

-

别让数据偏见毁了你的图像识别模型:嵌套交叉验证与数据增强组合拳

引言:当你的模型只认识“大多数” 搞图像识别的你,是不是经常遇到这种情况:训练数据里,猫狗图片一大堆,但你想识别的某种罕见鸟类或者特定病理切片,图片却少得可怜?这就是典型的**类别不平衡(Class Imbalance)**问题。直接...

-

嵌套交叉验证:获取可靠模型性能评估的终极武器

引言:超参数调优与模型评估的困境 在机器学习实践中,模型的性能很大程度上取决于超参数的选择。比如支持向量机(SVM)中的 C 和 gamma ,随机森林中的 n_estimators 和 max_depth 等等。找到最...

-

时间序列数据的交叉验证:陷阱、技巧与最佳实践

在机器学习中,交叉验证是评估模型泛化能力的重要手段。它通过将数据集划分为多个子集,轮流使用其中一部分进行训练,另一部分进行测试,从而减少模型评估的偏差。然而,当处理时间序列数据时,标准的交叉验证方法(如k折交叉验证)可能会失效,甚至导致错...

-

如何高效评估机器学习模型的表现?

在当今的数据驱动时代,机器学习已经成为解决诸多复杂问题的重要工具。然而,在构建出一个初步可用的模型后,接下来最关键的一步就是对其进行有效的评估。那么,有哪些有效的方法可以帮助我们全面了解一个机器学习模型的表现呢? 1. 划分训练集与测...

-

模型选择的“照妖镜” 交叉验证与信息准则的实战指南

作为一名在技术领域摸爬滚打多年的老鸟,我深知模型选择的重要性。一个好的模型,就像一把锋利的剑,能助你披荆斩棘;而一个糟糕的模型,则可能让你陷入泥潭,浪费时间和资源。在浩瀚的模型世界里,如何挑选出最适合自己的那个?今天,我就来和大家聊聊模型...

-

在特征工程中如何避免过拟合问题?

在机器学习中,特征工程是提升模型性能的重要步骤。然而,在特征工程过程中,我们常常会遇到过拟合的问题。过拟合是指模型在训练数据上表现良好,但在测试数据或新数据上表现较差的现象。本文将介绍几种在特征工程中避免过拟合的有效方法。 什么是过拟...

-

机器学习进阶:嵌套交叉验证在特征选择中的实战指南

你好,我是老码农。今天我们来聊聊机器学习中一个非常重要但容易被忽视的环节——特征选择,以及如何结合嵌套交叉验证(Nested Cross-Validation)来优雅地解决特征选择和模型评估的问题。对于经常需要同时处理特征工程和模型调优的...

-

深入理解模型混合与选择: 理论基础与实践指南

作为一名对机器学习充满热情的开发者,我们常常面临一个挑战:如何构建一个既准确又强大的模型?单一模型在解决复杂问题时往往力不从心。这时,模型混合与选择技术应运而生,它们就像一个工具箱,提供了多种组合和优化模型的方法。本文将深入探讨模型混合与...

-

Python时间序列数据分析:前向交叉验证的原理、实现与进阶

Python时间序列数据分析:前向交叉验证的原理、实现与进阶 嘿,大家好!今天咱们聊聊时间序列数据分析中的一个重要概念——前向交叉验证(Forward Chaining Cross-Validation)。 相信不少做过数据挖掘、机器...

-

金融风控中如何处理模型过拟合问题?

在金融行业,模型过拟合是一个非常常见但又令人头疼的问题。它通常指的是模型在训练数据上表现优异,但在新数据上的表现却大打折扣。简单来说,就是模型学到了数据的噪声而非真正的信号。以下是一些实用的方法,可以帮助我们处理模型过拟合问题。 1....

-

过拟合导致的金融预测模型偏差有多大?请用具体例子说明过拟合如何导致错误的投资决策和巨大的经济损失。

在现代金融科技飞速发展的今天,越来越多的投资者依赖机器学习模型来进行市场预测。然而,过拟合问题如同一把双刃剑,可能为决策者带来严重的经济损失。本文将深入探讨过拟合如何在金融预测中产生偏差。 过拟合的定义与影响 过拟合是指模型在训练...

-

模型优化中避免过拟合的十个实用技巧:从数据预处理到正则化策略

模型优化中避免过拟合的十个实用技巧:从数据预处理到正则化策略 过拟合是机器学习模型开发中一个常见且棘手的问题。它指的是模型在训练数据上表现良好,但在未见过的新数据上表现不佳。这通常是因为模型过于复杂,学习到了训练数据中的噪声或特例,而...

-

交互验证和交叉验证:机器学习中的双剑合璧

交互验证和交叉验证:机器学习中的双剑合璧 在机器学习领域,模型评估是至关重要的一环。我们不仅要关注模型的训练效果,更要评估模型在未知数据上的泛化能力。为了达到这一目标,交互验证 (Holdout Validation) 和交叉验证 (...

-

K折交叉验证:K值选择的艺术与科学 - 偏见、方差与计算成本的权衡

K折交叉验证:K值怎么选才靠谱? 在机器学习模型开发中,评估模型的泛化能力至关重要。我们希望模型在没见过的数据上也能表现良好,而不是仅仅拟合训练数据。K折交叉验证(K-Fold Cross-Validation)是实现这一目标最常用、...

-

AI预测软件缺陷:如何用机器学习算法提升代码质量?

在软件开发的世界里,缺陷是无处不在的幽灵,它们潜伏在代码的角落,伺机而动,可能导致系统崩溃、数据丢失,甚至安全漏洞。传统的测试方法虽然有效,但往往耗时耗力,难以覆盖所有潜在的风险点。那么,有没有一种方法,能够像预言家一样,提前预测软件中可...

-

如何利用Pandas和scikit-learn进行电商订单数据的预测分析

在使用Python进行数据分析时,Pandas和scikit-learn无疑是两个非常强大的工具。特别是在电商领域,通过分析订单数据来预测用户未来的购买行为或商品的销量,可以为电商企业提供宝贵的商业洞察。本文将结合具体案例,详细介绍如何使...

-

Python实战:高斯过程回归(GPR)中核函数的选择与交叉验证

深入浅出:高斯过程回归(GPR)中核函数的选择与优化 大家好!今天咱们聊聊高斯过程回归(Gaussian Process Regression,简称GPR)中一个核心问题——核函数的选择。别担心,我们会用大白话,加上Python代码实...

-

模型评估不再飘忽不定 重复K折交叉验证详解

引言:模型评估中的“随机性”困扰 嗨,各位奋战在机器学习前线的朋友们!咱们在训练模型时,评估其性能是个绕不开的关键环节。我们常常使用交叉验证(Cross-Validation, CV),特别是K折交叉验证(K-Fold CV),来估计...

-

交叉验证详解:K折、分层K折与留一法,选对才靠谱

兄弟们,咱们搞机器学习,模型训练完,总得知道它几斤几两吧?最常用的方法就是划分训练集和测试集。简单粗暴,一分为二,训练集练兵,测试集大考。但这就像高考前只做一套模拟题,万一这套题特别简单或者特别难,或者刚好考的都是你擅长/不擅长的知识点呢...

兄弟们,咱们搞机器学习,模型训练完,总得知道它几斤几两吧?最常用的方法就是划分训练集和测试集。简单粗暴,一分为二,训练集练兵,测试集大考。但这就像高考前只做一套模拟题,万一这套题特别简单或者特别难,或者刚好考的都是你擅长/不擅长的知识点呢...