交叉验证详解:K折、分层K折与留一法,选对才靠谱

兄弟们,咱们搞机器学习,模型训练完,总得知道它几斤几两吧?最常用的方法就是划分训练集和测试集。简单粗暴,一分为二,训练集练兵,测试集大考。但这就像高考前只做一套模拟题,万一这套题特别简单或者特别难,或者刚好考的都是你擅长/不擅长的知识点呢?这成绩能真实反映你的水平吗?悬!

同样道理,模型在某个特定测试集上的表现好,不代表它在未知新数据上也能一样牛。可能只是运气好,这个测试集刚好对模型的胃口。这就是所谓的过拟合于测试集(虽然程度较轻,但仍存在风险)。特别是数据量不大时,不同的划分方式可能导致模型评估结果差异巨大。咋办?

这时候,交叉验证(Cross-Validation, CV) 就该登场了。它就像组织了好几场模拟考,每次题目(数据)都不一样,最后综合几次成绩来看,评估结果更靠谱,更能反映模型的泛化能力(generalization ability)——也就是模型在从未见过的新数据上的表现能力。

交叉验证是个啥玩意儿?

简单来说,交叉验证的核心思想就是:重复利用数据。它不再是一次性地把数据分成训练集和固定的验证集(或测试集),而是把原始数据分成多份(称为“折”或“fold”),然后进行多次训练和验证。

具体来说:

- 分割(Splitting): 把整个数据集分成 K 个互不重叠的子集(通常大小相似)。

- 迭代(Iterating): 进行 K 次循环。在第 i 次循环中:

- 把第 i 个子集作为验证集(Validation Set)。

- 把剩下的 K-1 个子集合并起来作为训练集(Training Set)。

- 训练与评估(Training & Evaluating): 在当前的训练集上训练模型,然后在当前的验证集上评估模型性能,得到一个评估指标(比如准确率、F1分数、RMSE等)。

- 聚合(Aggregating): K 次循环结束后,我们得到了 K 个评估指标。通常计算这些指标的平均值和标准差。平均值作为模型最终性能的估计,标准差则反映了模型性能的稳定性(标准差小说明模型对不同数据划分不敏感,性能稳定)。

(图片来源: scikit-learn documentation - 一个典型的5折交叉验证示意图)

(图片来源: scikit-learn documentation - 一个典型的5折交叉验证示意图)

想象一下,你有100条数据,搞个5折交叉验证 (K=5)。

- 第一次:用数据1-80训练,数据81-100验证。

- 第二次:用数据1-60和81-100训练,数据61-80验证。

- ...依此类推

- 第五次:用数据21-100训练,数据1-20验证。

这样,每条数据都有机会当一次“考题”(验证数据),也被用于训练模型。数据利用率大大提高!

为啥要跟交叉验证“死磕”?

用交叉验证,好处多多:

- 更可靠的性能评估: 多次验证求平均,结果比单次划分更稳定、更接近模型在真实未知数据上的表现,有效降低了“运气”成分。

- 更高效的数据利用: 特别是在数据量比较金贵的情况下,交叉验证让每一部分数据都参与了训练和验证,榨干数据的价值。

- 辅助模型选择和调优: 当你有多个候选模型(比如SVM、随机森林、神经网络)或者需要调整模型的超参数(比如学习率、树的深度)时,可以用交叉验证来比较它们在相同数据上的平均性能,选出那个“普遍”表现最好的。

- 识别模型问题: 如果模型在各折上的性能差异很大(标准差大),可能说明模型对数据的划分很敏感,不够稳定,或者数据本身存在某些特性(比如分布不均)。

主流交叉验证策略:K折、分层K折、留一法

交叉验证有好几种玩法,适用于不同的场景。最常用的有这几种:

1. K折交叉验证 (K-Fold Cross-Validation)

这就是我们上面介绍的基本玩法。把数据分成 K 份,轮流做验证集。

- 优点:

- 所有数据点都有且仅有一次机会被用于验证。

- 所有数据点都被用于训练 K-1 次。

- 在偏差(bias)和方差(variance)之间取得了较好的平衡(相比单次划分或LOOCV)。

- 缺点:

- 需要训练 K 次模型,计算成本是单次划分的 K 倍。

- 如果 K 值取得很大,每次训练的数据量接近原始数据量,计算开销会很大。

- 致命伤(有时): 随机划分可能导致某些折中的类别分布与整体数据分布差异很大。尤其是在类别不平衡(imbalanced classes)的数据集上,某个折可能压根没有某个少数类的样本,或者比例严重失衡,导致该折的评估结果失去意义。

- 啥时候用?

- 最常用、最通用的交叉验证方法。

- 数据集相对均衡,或者对类别分布不敏感的回归问题。

- 通常 K 取 5 或 10 是经验上的好选择,兼顾了计算成本和评估效果。

代码时间 (Python with scikit-learn):

import numpy as np

from sklearn.model_selection import KFold

from sklearn.linear_model import LogisticRegression

from sklearn.metrics import accuracy_score

from sklearn.datasets import load_iris

# 准备数据和模型

X, y = load_iris(return_X_y=True)

model = LogisticRegression(max_iter=200) # 简单模型示例

# 设置K折交叉验证

k = 5

kf = KFold(n_splits=k, shuffle=True, random_state=42) # shuffle=True 建议开启,打乱数据再分折

fold_accuracies = [] # 存储每折的准确率

print(f"--- 开始 {k}-折交叉验证 ---")

# 迭代每一折

for fold, (train_index, val_index) in enumerate(kf.split(X, y)): # 注意 kf.split() 同时作用于 X 和 y

# print(f"Fold {fold+1}:")

# print(f" Train: index={train_index[:10]}... shape={train_index.shape}") # 显示前10个训练索引和形状

# print(f" Validation: index={val_index[:10]}... shape={val_index.shape}") # 显示前10个验证索引和形状

# 获取当前折的训练集和验证集

X_train, X_val = X[train_index], X[val_index]

y_train, y_val = y[train_index], y[val_index]

# 训练模型(注意:每次都在当前训练集上重新训练)

model.fit(X_train, y_train)

# 在验证集上进行预测和评估

y_pred = model.predict(X_val)

acc = accuracy_score(y_val, y_pred)

fold_accuracies.append(acc)

print(f"Fold {fold+1} 验证集准确率: {acc:.4f}")

# 计算并打印平均准确率和标准差

mean_accuracy = np.mean(fold_accuracies)

std_accuracy = np.std(fold_accuracies)

print("\n--- 交叉验证结果 ---")

print(f"各折准确率: {fold_accuracies}")

print(f"平均准确率: {mean_accuracy:.4f}")

print(f"准确率标准差: {std_accuracy:.4f}")

2. 分层K折交叉验证 (Stratified K-Fold Cross-Validation)

这是 K 折交叉验证的“升级版”,专门用来对付类别不平衡的数据集。

- 核心区别: 在划分 K 个折时,它会确保每个折内的类别比例与整个数据集的类别比例大致相同。

- 为啥需要? 想象一个二分类问题,95% 是 A 类,5% 是 B 类。如果用普通 K 折,某个倒霉的折里可能全是 A 类样本,那模型在这折上预测 B 类的能力就完全没法评估了。分层 K 折能避免这种情况。

- 优点:

- 在类别不平衡的数据集上,评估结果更可靠、更有代表性。

- 继承了 K 折的大部分优点。

- 缺点:

- 主要适用于分类问题。对于回归问题,分层的意义不大(除非你对目标值进行分箱处理,但那又是另一个故事了)。

- 计算成本与 K 折相同。

- 啥时候用?

- 强烈推荐用于任何分类任务,尤其是当你怀疑或已知数据存在类别不平衡时。

- 可以说,在分类问题上,用分层 K 折通常比普通 K 折更稳妥。

代码时间 (Python with scikit-learn):

import numpy as np

from sklearn.model_selection import StratifiedKFold # 注意导入的是 StratifiedKFold

from sklearn.linear_model import LogisticRegression

from sklearn.metrics import accuracy_score

from sklearn.datasets import make_classification # 使用 make_classification 创建一个可能不平衡的数据集

# 创建一个稍微不平衡的数据集 (例如 90% vs 10%)

X, y = make_classification(n_samples=1000, n_features=20, n_informative=2,

n_redundant=10, n_clusters_per_class=1, weights=[0.9, 0.1],

flip_y=0, random_state=42)

model = LogisticRegression(max_iter=200)

k = 5

skf = StratifiedKFold(n_splits=k, shuffle=True, random_state=42) # 使用 StratifiedKFold

fold_accuracies = []

print(f"--- 开始 {k}-折 分层 交叉验证 ---")

# 迭代每一折

# skf.split() 需要同时传入 X 和 y,因为它需要根据 y 来进行分层

for fold, (train_index, val_index) in enumerate(skf.split(X, y)):

X_train, X_val = X[train_index], X[val_index]

y_train, y_val = y[train_index], y[val_index]

# 检查一下分层效果 (可选)

# train_counts = np.bincount(y_train)

# val_counts = np.bincount(y_val)

# print(f"Fold {fold+1} Train counts: {train_counts}, Val counts: {val_counts}")

model.fit(X_train, y_train)

y_pred = model.predict(X_val)

acc = accuracy_score(y_val, y_pred)

fold_accuracies.append(acc)

print(f"Fold {fold+1} 验证集准确率: {acc:.4f}")

mean_accuracy = np.mean(fold_accuracies)

std_accuracy = np.std(fold_accuracies)

print("\n--- 交叉验证结果 ---")

print(f"各折准确率: {fold_accuracies}")

print(f"平均准确率: {mean_accuracy:.4f}")

print(f"准确率标准差: {std_accuracy:.4f}")

3. 留一法交叉验证 (Leave-One-Out Cross-Validation, LOOCV)

这是 K 折交叉验证的一个极端特例,当 K 等于数据集中的样本总数 N 时,就是留一法。

- 怎么玩: 进行 N 次迭代。每次迭代中,留下一个样本作为验证集,用剩下的 N-1 个样本进行训练。

- 优点:

- 最大化训练数据: 每次训练都用了几乎所有的数据,得到的模型最接近在整个数据集上训练的模型,因此评估结果的偏差(bias)通常很低。

- 确定性: 没有随机划分的步骤,每次运行 LOOCV 的结果都是一样的。

- 缺点:

- 计算成本极高: 需要训练 N 个模型!如果数据集稍大(比如几千条),这基本是不可接受的。训练一个模型要几分钟甚至几小时的话,跑完 LOOCV 可能要等到天荒地老。

- 高方差(variance): 虽然单次评估的偏差低,但每次验证集只有一个样本,导致单次评估结果对这个样本非常敏感,波动可能很大。最终平均性能的标准差可能较高,意味着评估结果本身不太稳定。

- 各次训练集之间高度重叠(只差一个样本),训练出的模型也非常相似,这进一步加剧了方差问题。

- 啥时候用?

- 数据集非常非常小(比如只有几十条数据)的时候,为了尽可能利用数据,可以考虑 LOOCV。

- 当计算成本不是主要瓶颈时(比如模型训练非常快)。

- 在某些需要极低偏差估计的特定研究场景。

代码时间 (Python with scikit-learn):

import numpy as np

from sklearn.model_selection import LeaveOneOut # 导入 LeaveOneOut

from sklearn.linear_model import LogisticRegression

from sklearn.metrics import accuracy_score

from sklearn.datasets import load_iris

# 使用小数据集示例

X, y = load_iris(return_X_y=True)

X = X[:50] # 只取前50个样本,模拟小数据集

y = y[:50]

n_samples = X.shape[0]

model = LogisticRegression(max_iter=100)

loo = LeaveOneOut()

fold_accuracies = []

print(f"--- 开始 留一法 (LOOCV) 交叉验证 (共 {n_samples} 折) ---")

# loo.split(X) 只需要 X,因为它不关心 y 的分层

for fold, (train_index, val_index) in enumerate(loo.split(X)):

# val_index 每次只有一个元素

# print(f"Fold {fold+1}: Train size {len(train_index)}, Val index {val_index}")

X_train, X_val = X[train_index], X[val_index]

y_train, y_val = y[train_index], y[val_index]

model.fit(X_train, y_train)

y_pred = model.predict(X_val)

acc = accuracy_score(y_val, y_pred) # 验证集只有一个样本,准确率非0即1

fold_accuracies.append(acc)

# if (fold + 1) % 10 == 0: # 每10折打印一次进度

# print(f"Processed fold {fold+1}/{n_samples}")

mean_accuracy = np.mean(fold_accuracies)

# LOOCV的标准差通常意义不大,因为每次评估都是基于单个样本

# std_accuracy = np.std(fold_accuracies)

print("\n--- 交叉验证结果 ---")

# print(f"各折准确率 (前20个): {fold_accuracies[:20]}...") # 太多了,只显示部分

print(f"平均准确率: {mean_accuracy:.4f}")

# print(f"准确率标准差: {std_accuracy:.4f}")

(补充) 其他变种:

- 留P法 (Leave-P-Out, LPO): 每次留下 P 个样本做验证,其余训练。当 P=1 时就是 LOOCV。组合数 C(N, P) 可能非常大,计算量爆炸,比 LOOCV 更甚,极少使用。

- 随机排列交叉验证 (Shuffle Split / Monte Carlo CV): 每次迭代都随机抽取一定比例(比如 80%)的数据作为训练集,剩余的(20%)作为验证集。可以指定迭代次数。与 K 折不同,不同迭代的验证集可能重叠,样本被选作验证的次数也可能不同。更灵活,但不如 K 折能保证所有数据都被验证一次。

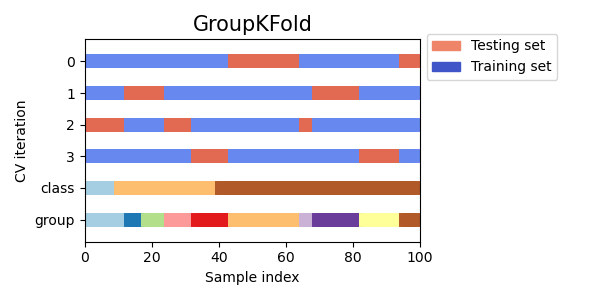

- 分组K折 (GroupKFold / StratifiedGroupKFold): 当数据中存在分组结构时(比如同一个病人的多次测量数据,或者同一个用户的多次访问记录),需要确保来自同一组的数据要么都在训练集,要么都在验证集,防止模型“记住”特定组的特性,从而高估泛化能力。

GroupKFold用于此目的,StratifiedGroupKFold则在分组的同时尽量保持类别平衡(比较复杂,需要特定条件)。

选哪个策略?K 值选多少?

选择困难症犯了?别慌,这有套路:

看任务类型和数据特点:

- 分类任务? 优先考虑 Stratified K-Fold,尤其是数据可能不平衡时。它基本是 K-Fold 的安全升级版。

- 回归任务? K-Fold 通常足够。

- 数据量极小? 可以考虑 LOOCV,但要掂量计算成本。

- 数据有分组结构? 必须用 GroupKFold 或其变种。

- 时间序列数据? 标准 CV 方法都不适用(会打乱时间顺序,导致用未来的数据预测过去,产生数据泄露)。需要用专门的时序交叉验证方法,如

TimeSeriesSplit(滚动预测)。

K值的选择 (主要针对 K-Fold 和 Stratified K-Fold):

- K=5 或 K=10 是最常见的选择,被大量实践和研究证明是偏差和方差之间不错的折衷点。

- K 值较小 (如 2 或 3):

- 优点:计算成本低。

- 缺点:每次训练集较小,评估结果的偏差可能较大(模型可能欠拟合);同时,验证集较大,单次评估的方差较小,但由于训练集变化大,最终平均结果的方差可能依然不小。

- K 值较大 (接近 N):

- 优点:每次训练集接近完整数据,模型偏差小。

- 缺点:计算成本高;训练集之间高度相似,导致模型也相似,评估结果的方差可能较大(类似 LOOCV)。

- 经验法则: 从 K=5 或 K=10 开始。如果计算资源允许且希望更可靠的估计,可以尝试 K=10。如果计算资源非常紧张,可以试试 K=3 或 K=5。

解读交叉验证结果:不只看平均值

跑完交叉验证,拿到一堆指标,怎么看?

- 平均性能 (Mean): 这是最重要的指标,代表了模型在当前数据分布下,对未知数据的预期表现。用它来比较不同模型或不同超参数设置。

- 性能标准差 (Standard Deviation): 反映了模型性能的稳定性。标准差小,说明模型在不同的数据子集上表现都差不多,比较稳健。标准差大,则说明模型性能波动剧烈,可能对数据的特定划分很敏感,或者模型本身不稳定。遇到这种情况要小心,高平均分+高标准差,可能意味着模型有时很好有时很糟。

- 结合使用: 比如模型 A 的平均准确率是 0.85 ± 0.02,模型 B 是 0.88 ± 0.08。虽然模型 B 平均分更高,但其稳定性远不如模型 A。选择哪个,取决于你的业务需求。是追求极致的平均性能,还是需要更稳定的表现?

交叉验证的结果常被用在:

GridSearchCV/RandomizedSearchCV: 这些超参数搜索工具内部就封装了交叉验证,它们会基于交叉验证的平均性能来确定最佳参数组合。- 最终模型评估:在选定模型和超参数后,有时会再跑一次交叉验证,得到最终的泛化性能估计值,并报告平均值和标准差。

关键大坑:数据泄露 (Data Leakage)!

这是使用交叉验证时最容易犯、也最致命的错误!数据泄露指在训练过程中,模型不应接触到的信息(通常是来自验证集或测试集的信息)意外地“泄露”给了模型,导致评估结果过于乐观,严重偏离真实泛化能力。

在交叉验证中,最常见的数据泄露形式是预处理步骤应用不当。

错误做法:

- 在整个数据集上进行预处理(如标准化

StandardScaler、归一化MinMaxScaler、特征选择SelectKBest、PCA 降维等)。 - 然后再将预处理后的数据喂给交叉验证流程。

# !!! 错误示例:数据泄露 !!!

from sklearn.preprocessing import StandardScaler

from sklearn.model_selection import cross_val_score

X, y = load_iris(return_X_y=True)

model = LogisticRegression()

# 1. 在整个数据集上进行标准化 (错误!)

scaler = StandardScaler()

X_scaled_wrong = scaler.fit_transform(X)

# 2. 然后用处理后的数据进行交叉验证

# cross_val_score 内部会做 K 折划分

# 但此时喂进去的数据已经包含了全局信息(均值和标准差)

scores = cross_val_score(model, X_scaled_wrong, y, cv=5, scoring='accuracy')

print(f"错误做法下的平均准确率: {np.mean(scores):.4f}") # 这个结果可能是虚高的

为什么错? 当你在整个数据集上 fit 预处理器(比如 StandardScaler 计算全局均值和标准差)时,这些全局信息包含了所有样本的信息,包括那些在后续交叉验证中会被用作验证集的样本。然后你用这些包含全局信息的转换器去 transform 数据,相当于在训练当前折的模型时,间接利用了当前折验证集的信息(通过全局均值/标准差等)。模型等于“偷看”了答案!

正确做法:

将预处理步骤包含在交叉验证的循环内部,或者使用 Pipeline 对象将预处理和模型打包在一起。

方法一:循环内部处理

# 正确做法 1: 在 CV 循环内部进行预处理

kf = StratifiedKFold(n_splits=5, shuffle=True, random_state=42)

fold_accuracies_correct = []

for fold, (train_index, val_index) in enumerate(kf.split(X, y)):

X_train, X_val = X[train_index], X[val_index]

y_train, y_val = y[train_index], y[val_index]

# 1. 在当前训练集 (X_train) 上 fit 预处理器

scaler_fold = StandardScaler()

X_train_scaled = scaler_fold.fit_transform(X_train)

# 2. 用同一个 scaler (只用 transform) 应用到验证集 (X_val)

X_val_scaled = scaler_fold.transform(X_val)

# 3. 用处理后的数据训练和验证

model_fold = LogisticRegression()

model_fold.fit(X_train_scaled, y_train)

y_pred = model_fold.predict(X_val_scaled)

acc = accuracy_score(y_val, y_pred)

fold_accuracies_correct.append(acc)

print(f"正确做法 (循环内) 平均准确率: {np.mean(fold_accuracies_correct):.4f}")

方法二:使用 Pipeline (推荐)

scikit-learn 的 Pipeline 可以将多个步骤(如预处理、模型训练)串联起来,形成一个单一的估计器。当 Pipeline 被用于 cross_val_score 或类似函数时,它能确保每一步(包括预处理的 fit)都只在当前交叉验证折的训练部分执行,自动避免数据泄露。

# 正确做法 2: 使用 Pipeline (推荐)

from sklearn.pipeline import Pipeline

# 1. 创建 Pipeline

# 包含 StandardScaler 和 LogisticRegression 两个步骤

pipe = Pipeline([

('scaler', StandardScaler()), # 步骤名称 'scaler', 对应的对象 StandardScaler()

('classifier', LogisticRegression()) # 步骤名称 'classifier', 对应的对象 LogisticRegression()

])

# 2. 将 Pipeline 作为一个整体估计器传入 cross_val_score

# cross_val_score 会自动处理好 Pipeline 内的 fit/transform 流程

scores_pipeline = cross_val_score(pipe, X, y, cv=5, scoring='accuracy') # 注意这里用原始 X

print(f"正确做法 (Pipeline) 平均准确率: {np.mean(scores_pipeline):.4f}")

务必记住:任何基于数据计算得到的转换逻辑(如均值、标准差、最大最小值、特征重要性、PCA主成分等),都必须只使用当前折的训练数据来计算,然后应用到训练集和验证集上。

结语:给模型一个公正的“体检”

交叉验证不是什么银弹,它不能 magically 提升你的模型性能,但它能给你一个更诚实、更可靠的性能评估。它帮助我们了解模型在面对未知数据时大概会有怎样的表现,指导我们做出更明智的模型选择和参数调整决策。

- K-Fold 是通用起点。

- Stratified K-Fold 是分类任务(尤其是不平衡数据)的首选。

- LOOCV 仅用于极小数据集或特殊场景。

- 永远警惕数据泄露,尤其是在预处理环节,善用

Pipeline。

下次当你评估模型时,别再只满足于一次简单的 train-test split 了。试试交叉验证,给你的模型来一次全面的“体检”吧!你会对它的真正实力有更清晰的认识。