评估

-

如何评估当前用户的安全风险等级? - 从小白到安全专家,一步步提升你的安全意识

如何评估当前用户的安全风险等级? - 从小白到安全专家,一步步提升你的安全意识 在互联网时代,网络安全已经成为每个人都必须关注的问题。从简单的密码泄露到复杂的网络攻击,各种安全威胁无处不在。因此,评估当前用户的安全风险等级至关重要,这...

-

交互验证和交叉验证:机器学习中的双剑合璧

交互验证和交叉验证:机器学习中的双剑合璧 在机器学习领域,模型评估是至关重要的一环。我们不仅要关注模型的训练效果,更要评估模型在未知数据上的泛化能力。为了达到这一目标,交互验证 (Holdout Validation) 和交叉验证 (...

-

如何评估不同模型的性能?

在机器学习和数据科学领域,模型的性能评估是一个至关重要的环节。无论是分类模型还是回归模型,评估其性能的方式都直接影响到我们对模型的理解和应用。 1. 模型评估的基本概念 模型评估是指通过一定的指标和方法来判断模型在特定任务上的表现...

-

模型评估的关键指标:如何判断你的模型是否真的有效?

模型评估的关键指标:如何判断你的模型是否真的有效? 在机器学习中,我们经常会训练各种模型来解决不同的问题。但是,如何判断一个模型是否有效?仅仅依靠训练集上的准确率就足够了吗?答案是否定的。我们需要借助模型评估指标来帮助我们判断模型的性...

-

模型评估在实际应用中的重要性:如何避免模型“只说不练”?

模型评估在实际应用中的重要性:如何避免模型“只说不练”? 在机器学习领域,我们经常会听到“模型评估”这个词。但模型评估到底有多重要?为什么它在实际应用中不可或缺? 简单来说,模型评估就像给模型进行“考试”,通过一系列指标来衡量模型...

-

时间序列预测模型评估:如何判断模型的好坏?

时间序列预测模型评估:如何判断模型的好坏? 时间序列预测是数据分析中常见的任务,例如预测未来销售额、股票价格、天气变化等。为了更好地评估模型的预测能力,需要对模型进行评估。那么,如何评估时间序列预测模型的好坏呢? 评估指标的选取 ...

-

边缘计算信任评估:兼谈实时性和确定性

边缘计算信任评估:兼谈实时性和确定性 在万物互联的时代,边缘计算作为一种新兴的计算范式,正在迅速崛起。它将计算和数据存储更靠近数据源,从而降低延迟,提高带宽效率,并增强数据安全性。然而,边缘计算环境的开放性和异构性也带来了新的安全挑战...

-

物联网设备安全评估:从硬件到云端的全方位考量

物联网(IoT)设备日益普及,为我们的生活带来了诸多便利,但也带来了前所未有的安全挑战。评估物联网设备的安全至关重要,这不仅关系到个人隐私,也关系到国家安全和社会稳定。那么,如何有效评估物联网设备的安全呢?这需要从硬件、软件、网络以及云端...

-

构建农机作业质量评估的特征体系:技术与实践

在现代农业中,农机作业的质量直接关系到农作物的产量和品质。因此,建立一个科学、全面的农机作业质量评估体系显得尤为重要。本文将深入探讨如何构建这样一个评估体系,包括其特征体系的构建方法、技术手段以及实际应用案例。 一、农机作业质量评估的...

-

SSL/TLS 协议安全评估终极指南:方法、工具与最佳实践

SSL/TLS 协议安全评估终极指南:方法、工具与最佳实践 在当今的互联网世界,安全通信至关重要。SSL/TLS 协议作为保护数据在客户端和服务器之间传输安全性的基石,其重要性不言而喻。然而,SSL/TLS 协议并非完美无缺,随着时间...

-

DAO成员贡献评估工具大盘点:Collab.Land、Guild.xyz 们如何助力资金分配?

“喂,兄弟,最近在玩 DAO 吗?” “玩啊,DAO 太酷了!去中心化、自治,感觉未来就在眼前!” “是啊,不过话说回来,DAO 里的贡献怎么算啊?大家一起做事,最后分钱的时候,总不能‘大锅饭’吧?” “这确实是个问题…......

-

Coordinape 的“互评”机制:风险与博弈论视角下的优化

大家好,我是币圈老猫。今天我们来聊聊一个在 DAO 治理和贡献者激励领域非常热门的话题——Coordinape。这个工具的核心是“互评”机制,它试图通过成员之间的相互评价来分配资金,从而激励贡献并衡量价值。听起来很美好对吧?但任何机制都有...

-

Coordinape 互评机制深度解析:如何应对“抱团”、“搭便车”等问题

Coordinape 作为一种在 DAO(去中心化自治组织)中分配资源和奖励的工具,其核心在于“互评机制”。成员之间相互评估贡献,并据此分配预设的资源。这种机制旨在鼓励协作、提高透明度,并促进社区驱动的价值评估。然而,任何机制都并非完美,...

-

时间序列交叉验证:不同场景下的最佳实践

在时间序列分析领域,交叉验证是一种至关重要的模型评估方法。然而,由于时间序列数据的特殊性——数据点之间存在时间依赖关系,传统的交叉验证方法(如 k-fold 交叉验证)无法直接应用于时间序列。因此,我们需要针对时间序列数据的特性,选择合适...

-

模型诊断工具在贝叶斯优化中的应用:收敛性与参数选择的稳定性评估

嘿,哥们!最近在搞贝叶斯优化?是不是也经常遇到收敛慢、参数调不好这些头疼的问题?别担心,咱们今天就来聊聊怎么用模型诊断工具,让你的贝叶斯优化飞起来! 贝叶斯优化:你的黑盒优化利器 简单来说,贝叶斯优化就像一个特别聪明的“调参侠”。...

-

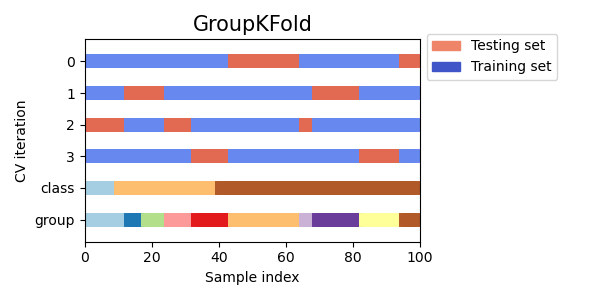

交叉验证详解:K折、分层K折与留一法,选对才靠谱

兄弟们,咱们搞机器学习,模型训练完,总得知道它几斤几两吧?最常用的方法就是划分训练集和测试集。简单粗暴,一分为二,训练集练兵,测试集大考。但这就像高考前只做一套模拟题,万一这套题特别简单或者特别难,或者刚好考的都是你擅长/不擅长的知识点呢...

兄弟们,咱们搞机器学习,模型训练完,总得知道它几斤几两吧?最常用的方法就是划分训练集和测试集。简单粗暴,一分为二,训练集练兵,测试集大考。但这就像高考前只做一套模拟题,万一这套题特别简单或者特别难,或者刚好考的都是你擅长/不擅长的知识点呢... -

机器学习进阶:嵌套交叉验证在特征选择中的实战指南

你好,我是老码农。今天我们来聊聊机器学习中一个非常重要但容易被忽视的环节——特征选择,以及如何结合嵌套交叉验证(Nested Cross-Validation)来优雅地解决特征选择和模型评估的问题。对于经常需要同时处理特征工程和模型调优的...

-

嵌套交叉验证:应对类别不平衡问题的终极指南

大家好,我是老码农。今天咱们来聊聊机器学习中一个非常棘手的问题——类别不平衡。这个问题就像是考试时偏科一样,严重影响了模型的整体表现。但别担心,我将带你深入了解嵌套交叉验证(Nested Cross-Validation),以及它在处理类...

-

用贝叶斯优化调教GAN生成器:让你的AI画出更惊艳的图像

GAN调参的痛,贝叶斯优化来拯救? 玩过生成对抗网络(GAN)的哥们儿都知道,这玩意儿效果惊艳,但训练起来简直是门玄学。生成器(Generator)和判别器(Discriminator)的爱恨情仇,动不动就模式崩溃(mode coll...

-

图像生成模型的透明化:特征重要性分析、决策路径可视化与可解释性评估

图像生成模型的透明化:特征重要性分析、决策路径可视化与可解释性评估 嘿,哥们儿,最近在捣鼓图像生成模型吗? 现在的AI图像生成工具是越来越厉害了,什么文生图、图生图,简直是艺术家们的福音啊。但是,你有没有想过,这些模型是怎么“思考”的...

兄弟们,咱们搞机器学习,模型训练完,总得知道它几斤几两吧?最常用的方法就是划分训练集和测试集。简单粗暴,一分为二,训练集练兵,测试集大考。但这就像高考前只做一套模拟题,万一这套题特别简单或者特别难,或者刚好考的都是你擅长/不擅长的知识点呢...

兄弟们,咱们搞机器学习,模型训练完,总得知道它几斤几两吧?最常用的方法就是划分训练集和测试集。简单粗暴,一分为二,训练集练兵,测试集大考。但这就像高考前只做一套模拟题,万一这套题特别简单或者特别难,或者刚好考的都是你擅长/不擅长的知识点呢...